[사진=게티이미지뱅크]

KT는 지난 27일 간담회를 통해 실제 AI 개발 환경에서 HAC 활용시 거둘 수 있는 기술적·경제적 이점을 구체화하고, HAC가 이 시장의 사실상 표준(de facto standard) 지위를 독점한 엔비디아 그래픽처리장치(GPU)의 비용효율적인 대안이 될 수 있음을 시사했다.

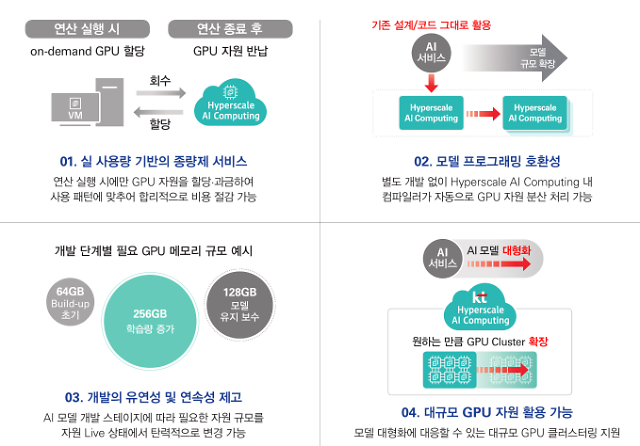

HAC는 지난 10일 KT 클라우드 기반 상품의 하나로 출시됐다. AI 학습·추론을 위한 'AI 가속기'를 제공한다. 사용자에게 필요한 컴퓨팅 자원을 즉각 내어 줄 수 있는 주문형(on-demand) 서비스이자, 자원을 쓴 만큼만 과금해 비용 효율성이 높은 종량제 서비스다.

KT는 HAC를 이용시 필요한 시점·기간에만 AI 모델 개발용 GPU 자원을 쓸 수 있다는 점, 하나의 서버에 연결된 GPU 갯수에 종속되지 않고 이론상 수백 내지 수천개가 연결된 GPU 자원으로 제공될 수 있어 확장성이 높다는 점을 강조하고 있다.

KT직원들이 KT 클라우드 데이터 센터에서 시스템을 점검하고 있다. [사진=KT]

그리고 HAC를 이용하면 AI 모델에 할당한 자원을 계속 고정해서 써야 하는 제약 없이, 연속적으로 증설하거나 감축할 수 있다. 모델의 크기에 맞춰 할당된 자원을 변경하느라 서비스를 일일이 중단하지 않아도 되는 만큼, 전체 개발기간도 단축해 준다.

KT는 GPU 자원을 증설하는 과정에서 선형적인 최대성능 증가 효과를 쉽게 얻을 수 있다는 점도 부각시켰다. 1개의 GPU에 맞춰진 초기 환경·코드를 재설계·재개발하지 않고 여러 GPU를 효율적으로 이용하는 단계로 매끄럽게 넘어갈 수 있다는 메시지다.

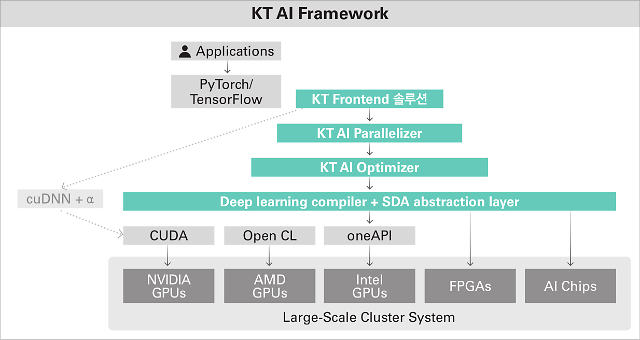

김종 KT 클라우드·IDC사업추진실 클라우드플랫폼담당 상무는 HAC에 대해 "업계 유일한 GPU 자원의 병렬 최적화와 동적 할당 기술을 소프트웨어 스택으로 구현해, 이용자 요청에 맞게 AMD GPU 중심으로 구성된 클러스터를 제어·제공한다"고 설명했다.

KT는 앞서 커먼컴퓨터와 협력해 '모두의연구소'의 학습용 플랫폼에 HAC 도입 환경을 구축하고 테스트를 진행했다. AI전문기업 '딥핑소스'가 HAC의 GPU자원 효율성을 검증하기도 했다. 내년 초 모두의연구소가 실제 AI개발 교육 수업에 HAC를 도입한다.

KT 하이퍼스케일 AI 컴퓨팅 서비스 특징 [자료=KT]

내년부터 2023년까지 AI 인프라 소프트웨어 기술을 중심으로 HAC의 수요를 발굴해 나갈 계획이다. 자체 AI반도체 기술을 활용해 2024년부터 소프트웨어·하드웨어를 결합한 '풀스택' 솔루션으로 HAC 서비스 사업을 확대하고, 이후 해외 시장에 도전한다.

HAC는 KT가 지난 10월 클라우드에서 대규모 AI를 구현·실행하는 인프라 솔루션 스타트업 '모레(Moreh)'와 맺은 AI 인프라 역량 강화 업무협약을 바탕으로 기획·출시됐다. 고성능분산·병렬 컴퓨팅, 딥러닝 개발 소프트웨어 전문가들이 모레의 핵심 멤버다.

HAC의 GPU 자원은 엔비디아의 병렬 프로그래밍 플랫폼 '쿠다(CUDA)' 디바이스로 인식되고, KT는 HAC 서비스상에서 CUDA 디바이스와 호환되는 API를 제공한다. 이로써 CUDA에 종속된 딥러닝 프레임워크 '파이토치'를 쓰는 기존 모델의 개발 효율을 높일 수 있다.

KT는 HAC 서비스에서 파이토치 기반 AI 추론 모델 중 비전·자연어처리·딥러닝추천 등 3개 분야에서 사용 빈도가 높은 41종의 학습·추론을 돕는 샘플 코드와 데이터 등을 순차 지원하겠다고 밝혔다. 내년 중 구글의 '텐서플로(TensorFlow)' 지원도 추가할 예정이다.

KT 하이퍼스케일 AI 컴퓨팅 서비스에 적용된 KT AI 프레임워크 아키텍처 [자료=KT]

©'5개국어 글로벌 경제신문' 아주경제. 무단전재·재배포 금지

![[르포] 중력 6배에 짓눌려 기절 직전…전투기 조종사 비행환경 적응훈련(영상)](https://image.ajunews.com/content/image/2024/02/29/20240229181518601151_258_161.jpg)